VUI( Voice User Interface : 音声ユーザーインターフェース)とは、ユーザーがデバイスに対して話しかけるとその発言を理解して、ユーザーの命令に応じて動作する機能のことだ。代表的なインターフェースとしてAppleのSiri、AmazonのAlexa、GoogleのGoogle Assistant、LINEのClovaなどが挙げられる。

VUIの先頭を走るアメリカでは、Gartnerの予測 )

「2020年までに全検索行為の50%が音声で行われるようになる」Comscoreの予測 )

Apple、Amazon、Google、IBM、Facebook、LINE…IT界の巨人企業がこぞってVUIに参入する理由とは?そしてもし、上記のような予測が本当になるのなら今後どういったことが考えられるのだろうか。

なぜ今気になるのか

私がVUIを意識したのは、昨年10月にAdobe XDに音声トリガーが搭載されたことによる。

未だにこの機能を実地で使ったことはないが、少なくとも昨年時点でAdobeは今後のVUIの伸びをを予測し、先んじてXDに機能として加えたのである。

また今年のGoogle I/OでのビッグトピックスのひとつであるGoogle Assistantの進化についてのデモ動画が私の関心に拍車をかけた。

100GBもあったデータを0.5GBまで縮小したことにより、スマートフォン上でローカル実行できるようになり、音声処理をほぼ遅延なし(ゼロレイテイシー)で処理できるようになった。ローカル実行によりネットワークに接続していないときでも使えるようになり、また次世代版ではユーザーのリクエストを理解・処理するまでのレスポンシブが最大10倍早くなるらしい。

また、Continued Conversation機能により「Hey Google」を何度も言わずに複数のリクエストが連続して行なわれる様子もデモ動画でわかる。

このGoogle Assistant次世代版は年内には新しいPixelに搭載予定だという。

VUIが注目される理由とは?

さて、冒頭にもあげたように今音声という新たなインターフェイスに多くの企業が可能性をみいだしている。Amazonは以下の4つのトレンドが音声技術の急速な普及を後押ししていると考察している。

1. ウェブサービスとIotの先に広がる世界 Internet of Things : モノのインターネット)は、音声技術にとって格好の舞台である。例えば、センサーと読み取り装置は、スマートホームインテグレーションをごく自然に実現してくれる。

2. 科学技術がより身近に

3. ハードウェアがユースケースに対応

4. AIによってVUIがよりスマートに

またAmazonは、この4つのトレンド以上に声というものが私たち人間ににとって一番自然なコミュニケーション方法であり、進歩を加速させた原動力とも述べている。

VUIの活用事例

音声で家電を制御するスマートホームは想像するにたやすいが他にどのようにVUIが私達の生活に組み込まれているのだろうか。その前に一度VUIのメリットとデメリットに触れたい。

VUIのメリット

1. ハンズフリーで両手が自由に使える

2. 目線を固定する必要がない

3. 話しかけるので学習が不要

VUIのデメリット

1. 情報の比較が難しい

2. 入力情報の誤認識が多い

さて、実際に事例をみよう。

Destiny2

My Starbucks barista

ECをはじめ、コマースもVUIが活躍しやすい分野といえる。決まっている商品を音声を通じて注文や決済できるイメージはすでに持っている人も多いだろう。

Starbucksがベータ版を発表している「My Starbucks barista」はチャットボットテクノロジーで会話しながらコーヒーを注文できるアプリだ。

一方的な命令ではなく、チャットによりコミュニケーションをとり、欲しい商品や情報を手にすることができる。電話で問い合わせたり、Webをチェックする必要がないことは大きな成果といえる。

ELLIQ

受動的なコミュニケーションにとどまらず、能動的にコミュニケーションをとろうとする対話ロボットも開発されている。

ElliQは高齢者が簡単に友達や家族、そして世の中とコミュニケーションを取れるようにすることを目標としている。「写真が届いたけど見たい?」「投稿に返信する?」「おくすりの時間だよ」「外出の予定があるよ」と積極的に話しかける様子は、アシスタントというよりもコンパニオンだ。

ElliQは高齢者とターゲットをしぼっているが、小さいこどもを持つ家庭などでも活躍しそうな技術である。

VUIの今後のトレンド

かなり様々なところでVUIが活用されはじめているが、今後はどんなところにこの技術は染み渡っていくのだろう。VUIのスペシャリストの株式会社WHITE 長友氏によると、

1. 身体的不自由を支援するサービス

実際にGoogleも今年のGoogle I/Oでは発声に不自由のある方の通話を補助するLive Relayのプロジェクトや発声に不自由がある方の音声・表情・ジェスチャーのデータを取り込んで、それぞれに合わせた発声AIをトレーニング・活用する「Project Euphonia」が発表された。

2. 無思考型サービス アクセンチュアが実施している調査 によると、企業やブランドに対する生活者の無関心化が進んでるという。何か買うときにこだわりを持たず、企業やブランドに対してロイヤリティを感じなくなっている、ということだ。これまでは何が欲しいのか明確になって検索して情報を探すというのが一般的だったものが、何がしたいのか自分でもよくわからない状態から買い物したりする人が増えてきている。VUIはこの流れに適しており、会話の中でAIがレコメンドしていき、何が欲しいのか、何をしたいのかという、生活者自身も気付いていないニーズが引き出されていくことが考えられる。

音声アシスタントは人間か?ロボットか?

もちろん音声アシスタントはロボットであるが、VUIに関して、私が個人的に気になっているのは、音声アシスタントの「人間らしさ」である。

「人間らしさ」と「ロボットらしさ」のバランスを保つことは、音声によるAIとのやり取りを設計するエンジニアにとって、かなりのチャレンジであることは想像に難くない。またこの問題は人々がヴァーチャルアシスタントに本当は何を求めているのかということに繋がる。

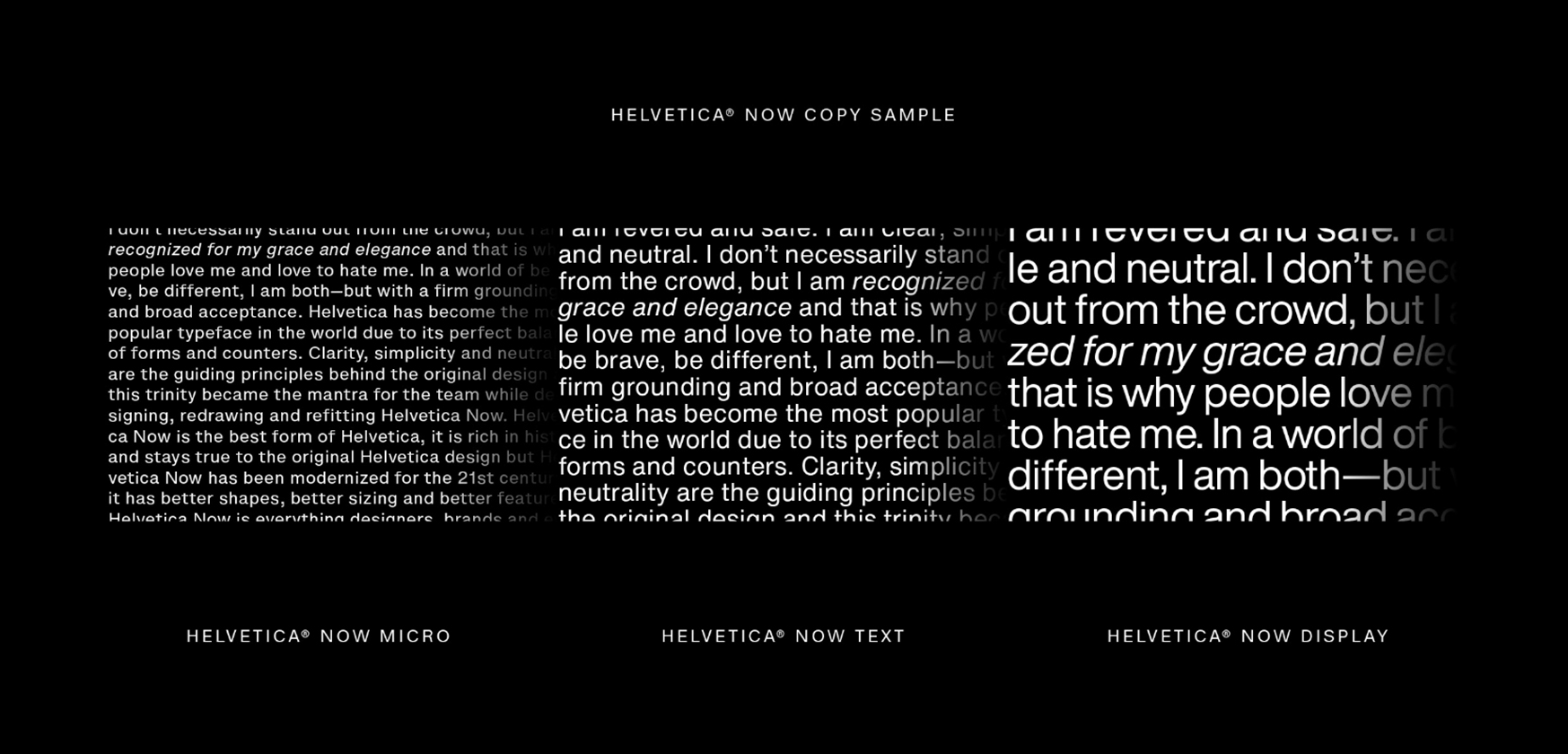

オハイオ州立大学の心理言語学者ローラ・ワグナー氏は、話し言葉における“音楽的”な要素は、聞き手の理解を助けるのだ、と語る。つまり、声のトーンや抑揚などによって微妙なニュアンスを伝えやすく、また聞き手が理解しやすくもなるのだ。

また、こうした話し方は感情がこもっているようにも聞こえるだろう。人はAIであれ、人間らしく聞こえると好感をもつ。音声アシスタントの話し方が人間らしく聞こえれば聞こえるほど、より信頼感を抱き、さらに使いたいと思うだろう、と氏は続ける。

一方音声アシスタントの個性を伸ばせは機能性が損なわれてしまう。音声アシスタントが「うーん」「えーと」などと言い始めたら、利用者も同じように話しかけるようになるはずだ。その結果、ユーザーが何を言っているのか認識できなくなる可能性が出てくる。つまり、ユーザーが音声アシスタントに丁寧に話しかけなくなり、言葉の認識率が下がってしまうかもしれないのだ。

さらに、書籍『The Conversational Interface(対話型インターフェース)』の著者の1人であるマイケル・マクティアー氏は、話し方があまりに人間らしいと、利用者にほかの面も非常に優れていると思い込ませてしまうかもしれない、と語る。天気予報を伝えたり、電気をつけたりするだけでなく、自分を理解してほしい、つながりを持ってほしい、デートをしてほしいとさえ望むかもしれない。期待が膨らむほど、アシスタントにできないことがあったとき、消費者の落胆も大きくなる。

どちらにせよ、人間らしくあってもロボットらしくあってもメリット・デメリットはでてくる。この中各社が音声アシスタントを人間にとってどこに位置づけていくのかは非常に興味深い。

音声アシスタントに性別は必要か? 「人間らしさ」からの派生であるが、この点についても引き続き動向を追いたい。

一般的な音声アシスタントは、男性と女性の声を選ぶことができるはずだ。しかし実際のところ、世界を男と女ではっきりと区別することは難しく、この2択は無意識に私達にある種のステレオタイプな考えを助長する可能性を潜めている。

つまり、気遣いができて役に立つAIアシスタントは女性の声を採用し、セキュリティロボットなどのマシンには男性の声を使って権威を示すべき、といったものだ。音声アシスタントの「Siri」や「Alexa」が女性の声であるのは偶然ではない。ユーザーは相手が男性の声より女性の声のほうが、より積極的にやりとりすることが研究で明らかになっているのだ。

言語学者、科学技術者、サウンドデザイナーからなるチームが、本物の人間の声をベースとする新しいジェンダーレスなデジタル音声「Q」によって、そんな状況を変えようとしている。このグループを率いているのは、LGBTの祭典として知られる「コペンハーゲン・プライド」と、Vice Media傘下のクリエイティヴエージェンシーであるVirtueだ。

男性らしさと女性らしさの判断は、主に周波数、すなわち音の高低に依存する。傾向として男性の声道は大きく、それにより声音が低くなる。だが、145ヘルツから175ヘルツの間にスイートスポットが存在し、この部分はより中性的に感じられることが、調査によって明らかになった。

この範囲よりも高くなると通常は女性の声として、それよりも低くなるとより男性らしい声として知覚されるのだ。

参考 : Meet Q

「Q」の開発チームはスイートスポットにちょうど当てはまった人物の声を調整し、最終的に4種類の声を作成、欧州に住む4500に聞いてもらった。結果はそのうちのひとつが中性的に聞こえるものとして多く票を集めることになる。この声がまさに「Q」のベースとなった。

公平性のために言っておくと、テクノロジー企業が必ずしも故意に、男女という2つだけのの選択肢にうまく収まらない声を除外しているわけではない。だが間違いなく、テック企業はジェンダーレスの声のようなものを開発する能力をもっている。控えめに言っても、製品で標準設定されている声についてこれまで以上に真剣に考え始めることができるはずだ。

しかし、これは簡単な問題ではない。人間の脳は、性別を厳密に男性または女性とみなすように文化的にプログラムされているからだ。言語学者のクリスティーナ・ハルグレンは、「Q」は、わたしたちの心にかかわるからこそ重要なのだと説明する。このプロジェクトは人々を箱に押し込めようとする人間の衝動に取り組むもの。ゆえに、人間の境界を動かし、視野を広げる可能性を秘めている、と続ける。

ジェンダーや人種の話をするといつもなんて世界は複雑なのだろうと思う。同時に私のバイアスが仕事や発言に反映させて誰かを傷つけていたらどうしようと恐ろしくなる。このようなプロジェクトは無意識下にある問題を見える化し、急速に変化する未来をより包摂的かつ啓蒙的なものへとかたちづくる一歩になって欲しい、そう願わずにはいられない。